Сравнение безопасности моделей Meta и Mistral и итоги проверки усиливают планы Министерства науки и ИКТ по оценке отечественных и зарубежных систем искусственного интеллекта; расширение тестирования ожидается после вступления в силу «Основного закона об ИИ» в январе 2026 года.

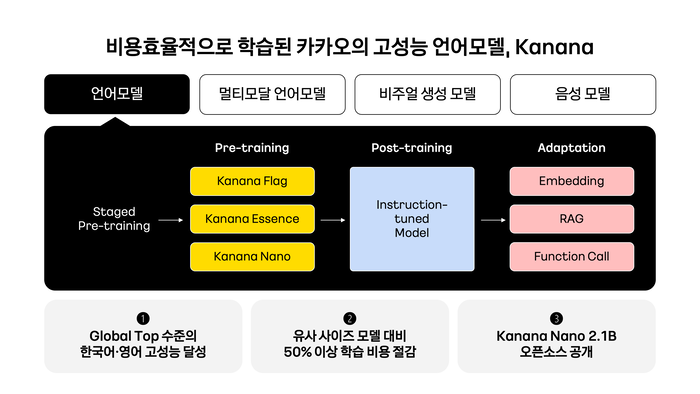

Модель искусственного интеллекта компании Kakao «Kana Essence 1.59.8B» показала более высокий уровень безопасности по сравнению с некоторыми зарубежными аналогами в первой в Южной Корее оценке безопасности ИИ.

Министерство науки и ИКТ объявило 29 декабря 2025 года о завершении оценки безопасности модели Kakao, проведённой совместно с Институтом исследований безопасности ИИ и Ассоциацией информационно-коммуникационных технологий Кореи (TTA). Это первая в стране официальная оценка безопасности ИИ.

Оценка проводилась в рамках подготовки государства к обеспечению безопасности высокопроизводительных моделей в преддверии вступления в силу «Основного закона об ИИ» в январе 2026 года. После начала действия закона модели, отнесённые к категории высокопроизводительных ИИ, будут обязаны обеспечивать соответствующие требования безопасности.

Объектом проверки стала модель «Kana Essence 1.59.8B», которая в линейке Kakao относится к моделям средних размеров. Компания Kakao участвовала в национальном консорциуме по безопасности ИИ и, по всей видимости, согласовывала проведение этой оценки с органами.

В процессе валидации использовались набор данных «AsurAI», разработанный командами TTA и KAIST, а также наборы для оценки высоких рисков Института исследований безопасности ИИ. Методика заключалась во вставке вопросов из этих наборов и оценке ответов модели.

Оценочная группа учитывала как общие факторы риска — насилие и дискриминационные высказывания, так и сценарии с высоким потенциалом злоупотребления, включая темы, связанные с оружием и безопасностью. По результатам проверки было зафиксировано, что модель обеспечила высокий уровень безопасности по сравнению с упомянутыми зарубежными моделями Meta «Rama 3.1» и Mistral «Mistral 0.3».

Министерство науки и ИКТ планирует применить процедуру оценки безопасности к первой фазе собственного проекта по созданию базовой AI-модели, запланированной на январь 2026 года, а также расширить проверку на другие модели в сотрудничестве с отечественными и зарубежными компаниями.

Ким Кён-ман, руководитель отдела политики в области искусственного интеллекта Министерства науки и ИКТ, отметил, что эта проверка служит примером подтверждения конкурентоспособности отечественных моделей по безопасности в условиях, когда международная дискуссия всё больше смещается с разработки регуляций на практическую верификацию и внедрение мер безопасности.

Комментариев