Модели Kimi K2 Thinking от Moonshot AI, DeepSeek-R1 от DeepSeek AI и Mistral Large 3 демонстрируют заметный прогресс в области искусственного интеллекта благодаря использованию архитектуры mixture-of-experts (MoE). При запуске на стеке NVIDIA GB200 NVL72 эти модели показывают примерно десятикратное увеличение производительности.

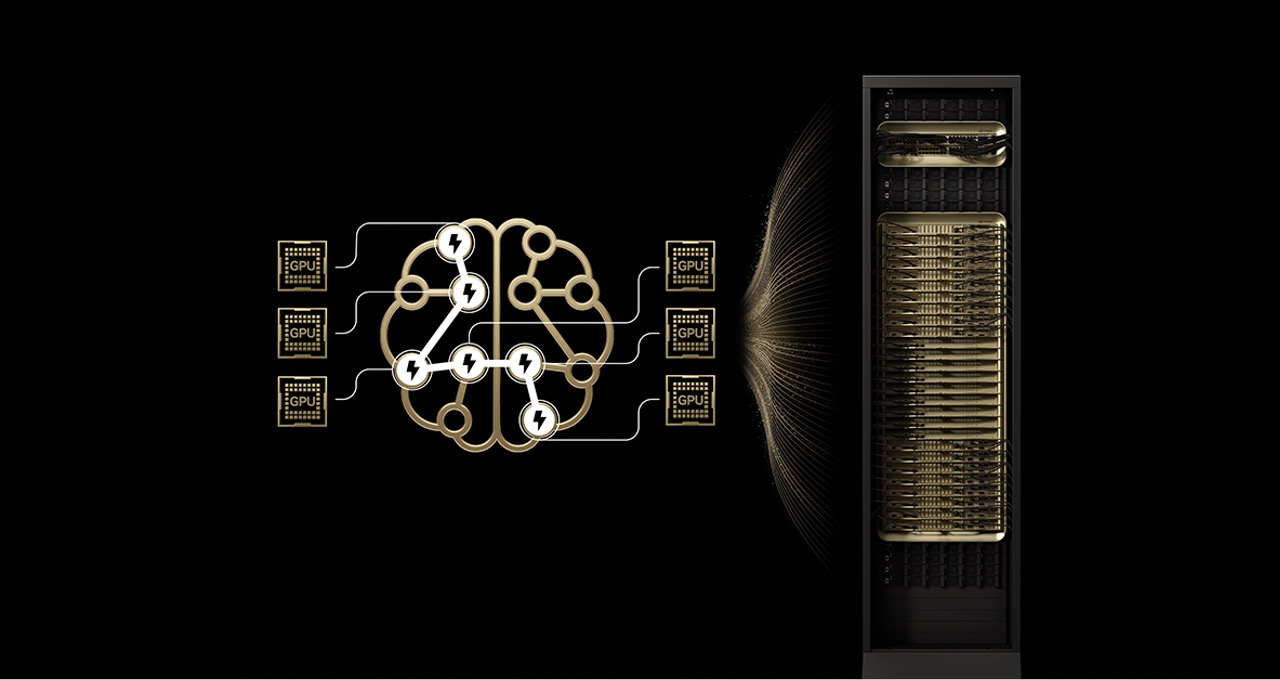

Архитектура MoE распределяет вычисления между набором специализированных «экспертов», активация которых зависит от конкретного токена, обрабатываемого моделью. Это позволяет генерировать токены быстрее и эффективнее, не требуя пропорционального роста вычислительных ресурсов.

Вместо использования всех параметров для каждого токена, MoE-модели задействуют только часть параметров — обычно десятки миллиардов из сотен миллиардов общей модели. Такая селективная активация повышает соотношение «интеллект — затраты», что ускорило развитие ведущих моделей в последние годы.

Аппаратная платформа NVIDIA GB200 NVL72 решает основные ограничивающие факторы масштабирования MoE за счёт объединения до 72 GPU Blackwell в единый связный кластер. Высокоскоростная NVLink-связь обеспечивает значительную пропускную способность для обмена между экспертами и снижает нагрузку на память отдельных GPU.

Система GB200 NVL72 заявляет о пропускной способности NVLink порядка 130 ТБ/с и общей производительности на уровне экзафлопсного класса с большим объёмом быстрой общей памяти. Такое сочетание аппаратного дизайна и общей памяти уменьшает давление на HBM и облегчает распределение экспертов по большему числу GPU.

Кроме аппаратного уровня, для эффективной работы MoE применяются программные оптимизации, включая фреймворки и форматы данных, ориентированные на ускорение инференса. Эти решения повышают производительность и позволяют эффективно использовать распределённую структуру экспертов в промышленных развертываниях.

Ранее масштабирование MoE ограничивалось необходимостью обмена данными между небольшим числом GPU, что увеличивало задержки и снижало выгоду от параллелизма экспертов. GB200 NVL72 снимает эти ограничения за счёт более широкой и быстрой межсоединённой сети, что даёт возможность распределять экспертов по 72 GPU и сокращать число экспертов на отдельный GPU.

В результате улучшаются показатели параллелизма экспертов, растёт пропускная способность при одновременном обслуживании большего числа пользователей и поддерживается обработка более длинных входных последовательностей. Это повышает практическую применимость MoE в задачах с высокими требованиями к инференсу.

Конкретные MoE-модели показали значимый рост производительности на GB200 NVL72 по сравнению с предыдущими системами, что подтверждает эффективность подхода для передовых AI-задач. Такую выгоду отмечают несколько разработчиков открытых моделей, применяющих MoE в своих решениях.

Крупные облачные провайдеры внедряют платформы на базе GB200 NVL72, чтобы предоставить клиентам доступ к масштабируемому MoE-инференсу в продакшне. Это позволяет компаниям и разработчикам запускать ресурсоёмкие модели и рабочие процессы с агентными компонентами на мощных специализированных кластерах.

В итоге сочетание архитектуры MoE и специализированных rack-scale систем даёт путь к более эффективному масштабированию интеллекта в открытых и коммерческих моделях. Аппаратно-программное согласование и распределение экспертов делают MoE предпочтительным выбором для ведущих разработок в области frontier AI.

Комментариев