Организации всё чаще стремятся извлекать инсайты из видео, аудио и других сложных источников данных. Подход с дополнением генерации извлечёнными данными (retrieval-augmented generation, RAG) позволяет системам генеративного ИИ использовать корпоративные данные. При этом включение видео в такие рабочие процессы создаёт дополнительные технические задачи, связанные с эффективным приёмом, индексированием и соблюдением требований в гетерогенной среде данных.

В этой статье описан интегрированный метод обогащения анализа и суммаризации видео за счёт сочетания Blueprint для поиска и суммаризации видео (VSS) и Blueprint для RAG. Комбинирование этих рабочих процессов даёт возможность дополнять понимание видео проверенными и контекстуально богатыми корпоративными данными, раскрывая более глубокие инсайты для критичных бизнес-приложений.

Читатель узнает, как объединить VSS и RAG для мультимодального поиска и суммаризации, как дополнять видеоаналитику корпоративными знаниями, как строить масштабируемые модульные рабочие процессы для Q&A и суммаризации в реальном времени, а также как применять эти решения в практических сценариях различных отраслей.

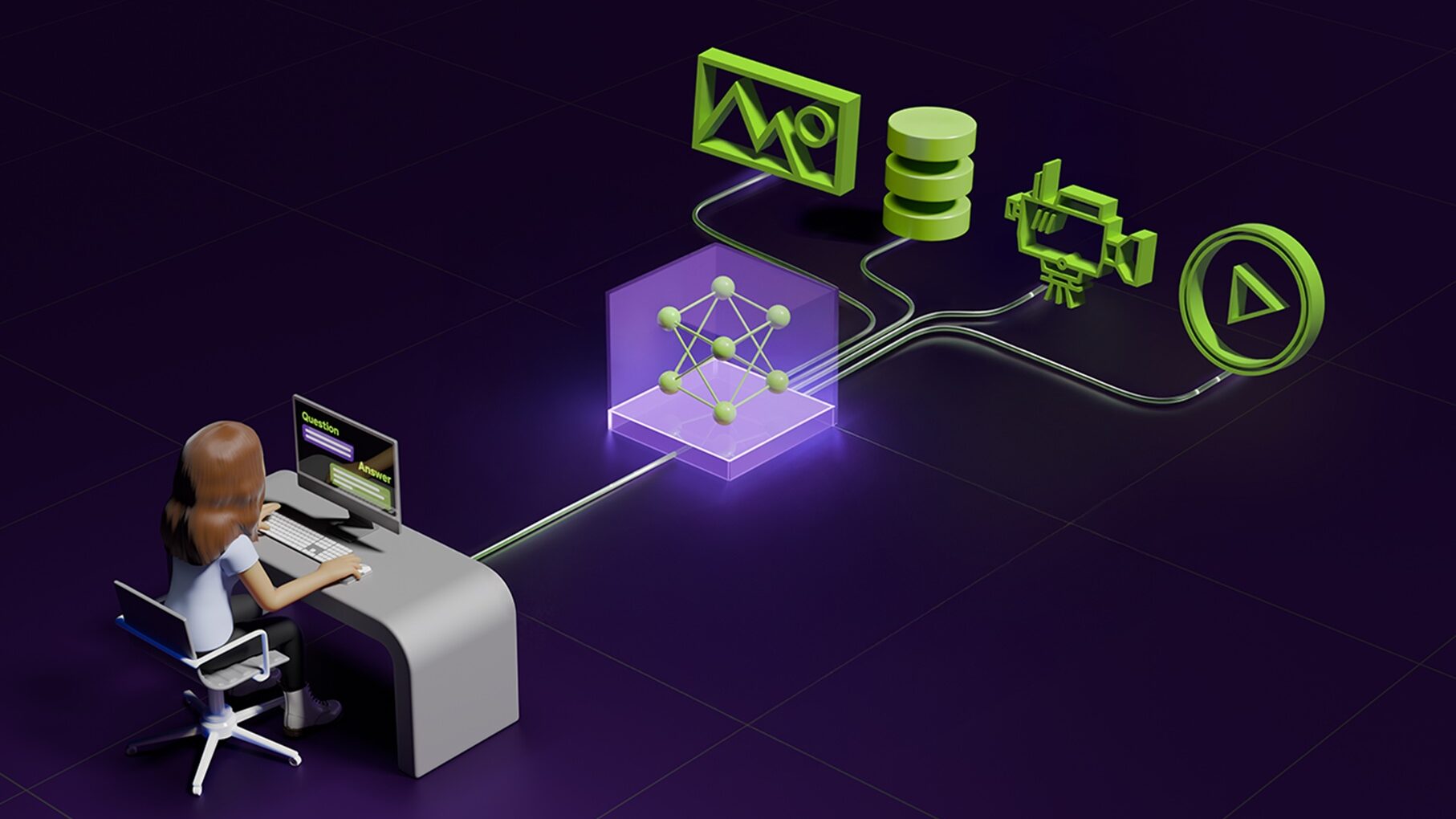

NVIDIA AI Blueprints представляют собой настраиваемые эталонные рабочие процессы для создания конвейеров генеративного ИИ. RAG-Blueprint опирается на модели NeMo Retriever и служит для непрерывного индексирования мультимодальных документов и быстрого семантического поиска в масштабе предприятия. VSS-Blueprint отвечает за приём больших объёмов стримингового или архивного видео для поиска, суммаризации, интерактивного Q&A и действий по событиям, например оповещений.

В качестве практического примера приведено сравнение исходного вывода VSS и итогового вывода, обогащённого через RAG. На вход подаётся видео с приготовлением завтрака; в первом варианте VSS даёт фактологическое описание наблюдаемых действий, сгруппированных по категориям, но без привязки к питательной ценности.

После интеграции с RAG VSS использует внешние руководства и справочные материалы по питанию, чтобы добавить контекст. Обогащённая сводка связывает наблюдаемые действия с пользой выбора цельных зёрен, значением клетчатки, питательной ценностью молочных продуктов и значением гигиены при работе с пищей.

Связь понимания видео с внешними знаниями делает выводы более практичными: зрителю становится проще принимать информированные решения о выборе продуктов и привычках питания на основе переведённой в понятную форму информации.

Для развёртывания решения предполагается, что RAG-Blueprint уже установлен и доступен через удалённую конечную точку. Примерный процесс развёртывания включает получение и развёртывание RAG-Blueprint, клонирование репозитория с реализацией VSS, внесение патчей интеграции в сборку контейнера и следование инструкциям по развёртыванию VSS с учётом внесённых изменений.

Тестирование интеграции выполняется запуском процесса VSS в среде оркестрации и передачей в него «декорированного» запроса, в котором часть запроса помечается для отправки в RAG. Эта пометка указывает VSS переслать подзапрос на внешний сервер RAG и затем использовать возвращённый контекст при генерации итогового ответа.

Возвращённый RAG контекст вставляется в настраиваемый шаблон обогащения перед вызовом LLM. Шаблон просит органично включить релевантные факты о питании, правила по безопасности пищевых продуктов и практические рекомендации, связывая наблюдаемые в видео действия с их возможной пользой для здоровья и повседневными выбором.

Механика работы включает приём и индексирование: VSS формирует сегменты и субтитры, а RAG индексирует корпоративные документы в GPU-ускоряемом векторном хранилище. При запросе пользователя VSS сначала выделяет кандидатные сегменты видео и параллельно запрашивает релевантные знания из RAG. Затем извлечённый контекст подаётся в LLM для синтеза обоснованного ответа, который сочетает видеоданные и внешний контекст.

Архитектура построена модульно и основана на API: VSS и RAG развернуты как отдельные сервисы и обмениваются подзапросами и контекстом. Такой подход позволяет использовать blueprints совместно или отдельно, масштабировать их независимо и быстро подключать новые сценарии без повторного индексирования исходных видео.

Композиция нескольких Blueprints даёт разработчикам возможность интегрировать специализированные пайплайны — например, обработку видео и корпоративный поиск — для решения межфункциональных задач. Это ускоряет разработку, облегчает кросс‑командное взаимодействие и повышает качество результатов за счёт добавления тематических экспертных данных.

Архитектурное решение держать RAG в отдельном сервисе обусловлено практическими соображениями: единый RAG-сервер обслуживает разные рабочие потоки и приложения, позволяет масштабировать обработку документов отдельно от видео, облегчает обновления и усиление безопасности, а также минимизирует накладные расходы интеграции, поскольку VSS требует только конечную точку RAG и параметры окружения.

По оценкам, суммарная задержка системы складывается из времени на операции VSS, RAG и генерацию LLM. В приведённом примере время извлечения RAG составляет порядка 1.7–1.8 секунды, фаза слияния с LLM — примерно 1.2–1.4 секунды, при этом конечное сквозное время для задач суммаризации и интерактивного чата существенно различается в зависимости от сценария. Для чат‑Q&A добавление RAG обычно даёт около 10% к общей задержке, а обогащение суммаризации — примерно 1%.

Интеграция VSS и RAG применяется в разных отраслях: на стройплощадках технология помогает отслеживать ход работ и улучшать безопасность, в лесном хозяйстве используется для обнаружения зарастания и инвазивных видов с генерацией отчётов, а в спортивной индустрии — для быстрой генерации персонализированных хайлайтов из больших хранилищ контента.

В результате модульная композиция специализированных blueprints позволяет компаниям переводить необработанное видео в ценные, контекстно обоснованные инсайты, сохраняя гибкость развёртывания и масштабирования в реальных корпоративных условиях.

Комментариев