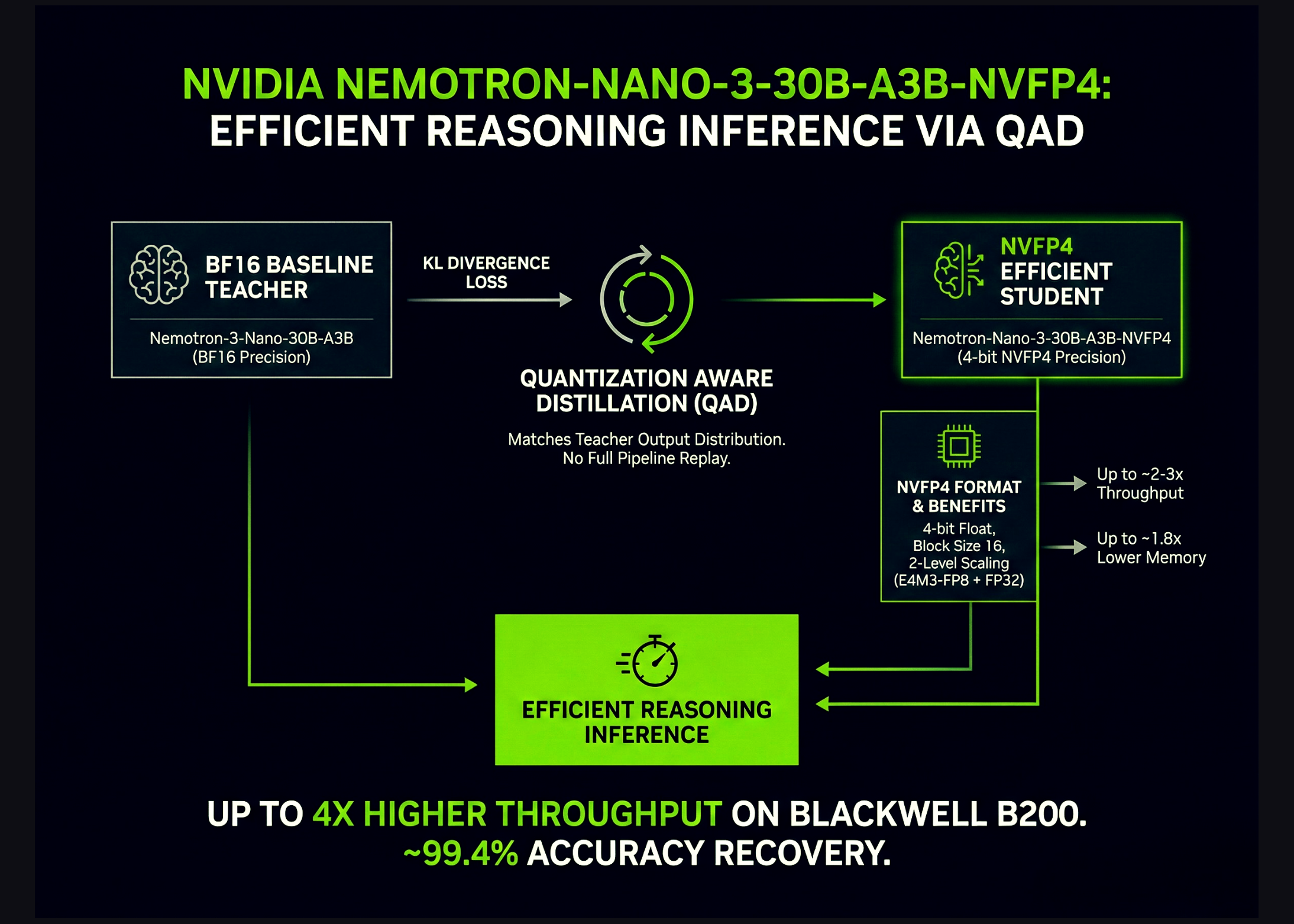

NVIDIA выпустила production‑чекпоинт Nemotron-Nano-3-30B-A3B-NVFP4 — 30‑миллиардную модель рассуждений в 4‑битном формате NVFP4, сохраняющую точность, близкую к BF16‑эталону. Модель сочетает гибридную архитектуру Mamba2 Transformer MoE с рецептом Quantization Aware Distillation (QAD), оптимизированным для развертывания в NVFP4. По данным разработчиков, версия в NVFP4 обеспечивает до 4× большую пропускную способность на ускорителях Blackwell B200.

Архитектура модели представляет собой гибрид Mamba2 Transformer MoE: суммарно 30 миллиардов параметров и 52 слоя глубины. В структуре выделены 23 слоя Mamba2/MoE и шесть слоёв сгруппированного запроса внимания с двумя группами.

Каждый MoE‑слой содержит 128 маршрутизируемых экспертов и один общий эксперт. При активации по шесть экспертов на токен это даёт примерно 3.5 миллиарда активных параметров на токен.

Модель предобучалась на 25 триллионах токенов с использованием расписания скорости обучения Warmup Stable Decay, батч‑размером 3072, пиковым шагом обучения 1e‑3 и минимальным 1e‑5. Последующая донастройка выполнена в три этапа.

Первый этап пост‑тренинга — супервизированная дообучение на синтетических и кураторских данных для задач кода, математики, науки, вызова инструментов, следования инструкциям и структурированных ответов. Второй этап — обучение с подкреплением, включая синхронный GRPO для многошагового использования инструментов, многопоточого чата и RLHF с генеративной моделью вознаграждения. Третий этап — пост‑тренировочная квантизация в NVFP4 с использованием FP8 для KV‑кэша и выборочной высокоточной раскладки, за которой следует QAD.

В финальном NVFP4‑чекпоинте слои внимания и Mamba‑слои, подающие в них, сохраняются в BF16, остальные слои квантуются в NVFP4, а KV‑кэш хранится в формате FP8. Такое сочетание обеспечивает баланс между стабильностью и экономией памяти.

NVFP4 — это 4‑битный формат с плавающей запятой, разработанный для обучения и инференса на современных GPU NVIDIA. По сравнению с FP8 он даёт примерно в 2–3 раза большую арифметическую пропускную способность и уменьшает объём памяти для весов и активаций примерно в 1.8 раза.

Формат NVFP4 расширяет схему MXFP4: он уменьшает размер блока с 32 до 16 и вводит двухуровневое масштабирование. Двухуровневое масштабирование использует E4M3‑FP8 шкалы на блок и FP32‑шкалу на тензор, что позволяет лучше подстраиваться под локальную статистику и расширяет динамический диапазон при низкой ошибке квантования.

Авторы отмечают, что для очень больших моделей простая пост‑тренировочная квантизация (PTQ) в NVFP4 уже обеспечивает приемлемую точность по ряду бенчмарков. Для более компактных или интенсивно дообучавшихся моделей PTQ может вызывать заметные потери точности, что мотивирует применение методов восстановления через обучение.

Традиционное Quantization Aware Training (QAT) вводит псевдо‑квантизацию в прямой проход и повторно использует исходную задачу (например, кросс‑энтропию следующего токена). Исследователи указывают две проблемы для современных больших языковых моделей: сложные многоступенчатые пост‑тренировочные пайплайны трудно воспроизвести, а исходные тренировочные данные часто недоступны.

Quantization Aware Distillation (QAD) меняет цель обучения: зафиксированная BF16‑модель выступает учителем, а NVFP4‑модель — учеником. Обучение минимизирует KL‑дивергенцию между распределениями выходных токенов учителя и ученика, а не исходную супервизированную или RL‑цель.

Авторы выделяют три ключевых свойства QAD: оно точнее выравнивает квантизированную модель с высокоточным учителем, остаётся стабильным при наличии у учителя многоступенчатой подготовки (SFT, RL, слияния моделей), и работает с частичными, синтетическими или отфильтрованными данными, поскольку требует лишь входного текста для запросов к учителю и ученику.

В работе Nemotron-3-Nano-30B‑A3B использовался в качестве примера модели с серьёзной долей RL‑обучения. По набору задач рассуждений и программирования (AA‑LCR, AIME25, GPQA‑D, LiveCodeBench‑v5, SciCode‑TQ) авторы показывают, что NVFP4‑PTQ даёт заметное падение точности, NVFP4‑QAT ухудшает её дальше, а NVFP4‑QAD восстанавливает результаты близко к BF16.

По результатам экспериментов NVFP4‑версия, обученная с помощью QAD, достигает до 99.4% точности относительно BF16‑эталона. В сумме это демонстрирует возможность значительной экономии памяти и ускорения инференса при минимальном ухудшении качества через комбинирование NVFP4 и QAD.

Комментариев